Dans notre dernière chronique, nous avons abordé le sujet du plus vieil élément de l’histoire de la reproduction sonore à être encore utilisé de nos jours, le disque. Il y a encore beaucoup à dire au sujet de ce patriarche qui a encore la cote de nos jours. Allons-y donc en examinant la question mystérieuse des vitesses de rotation.

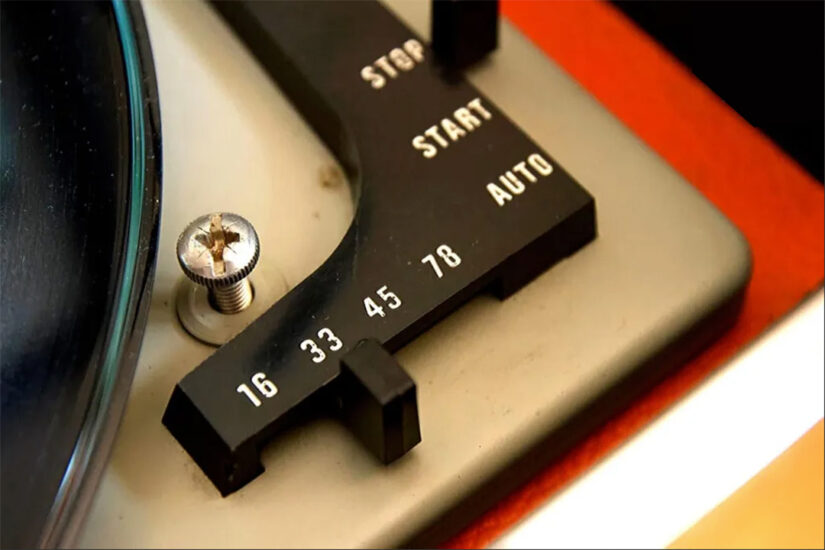

Les premiers disques étaient gravés à une vitesse variant entre 60 et 130 RPM, la valeur étant imprécise en bonne partie parce que des entraînements mécaniques primitifs étaient utilisés. Progressivement, on développa des systèmes de régulation plus évolués, et les manufacturiers adoptèrent la vitesse de 78 RPM. En réalité, la vitesse de rotation est de 78.26 RPM pour des raisons pratiques.

Lorsque les premiers moteurs électriques synchrones firent leur apparition sur le marché, leur vitesse de rotation étant déterminée par la fréquence de l’alimentation électrique, nous avions finalement la possibilité d’avoir une référence. La vitesse d’un tel moteur est déterminée par la fréquence de l’alimentation électrique, soit 60 Hz pour l’Amérique où ces moteurs furent développés.

Un moteur à deux pôles effectuant 60 rotations par seconde, on obtenait une vitesse référence de 3 600 RPM. En divisant ce nombre par un facteur de 46 à l’aide d’engrenages conventionnels, on arrivait au chiffre de 78.26.

Malheureusement, cette vitesse élevée et la largeur des sillons limitaient chaque face d’un disque à une durée d’environ 3 minutes pour un disque de 10 pouces et 5 minutes pour un 12 pouces, ce qui était suffisant pour la musique populaire et jusqu’à un certain point le Jazz, mais qui posait de sérieux problèmes pour les enregistrements d’œuvres classiques, dont la durée d’un mouvement dépasse très fréquemment cette limite. Il fallait donc trouver une solution à cette importante limitation.

Avec l’arrivée du microsillon (de l’anglais microgroove), littéralement un disque dont les sillons étaient moins larges, la vitesse de 33 1/3 RPM fut adoptée. L’origine de ce nombre est plutôt nébuleux, mais on peut supposer qu’il s’agissait encore une fois d’un rapport direct avec 3 600 RPM, puisqu’on arrive exactement à ce chiffre avec une démultiplication par un facteur de 108. Le nouveau format permettait finalement une durée d’enregistrement beaucoup plus longue sans perte de qualité causée par la réduction de vitesse, grâce aux progrès qui avaient été accomplis avec l’introduction de l’amplification électronique.

Le long-jeu (LP ou long playing, en anglais) était arrivé. En tenant compte des paramètres optimaux de gravure, on pouvait maintenant obtenir 17 minutes de musique par face d’un disque de 12 po, et au-delà de 20 si on acceptait de faire certains compromis au niveau de la dynamique. De nouvelles perspectives s’ouvraient pour le contenu musical. Cependant, bien que le LP fut développé au début des années 1930, soit en même temps que l’amplification à tubes et grâce aux possibilités qu’elle offrait, il fallut attendre jusqu’en 1948 pour que Columbia en commence la commercialisation, principalement à cause de la situation économique difficile.

Il restait par contre une étape à franchir pour que le média atteigne sa maturité, soit l’arrivée de la norme RIAA en 1952. Comme nous l’avons vu dans la précédente chronique, celle-ci permettait finalement d’améliorer la réponse dynamique en réduisant la largeur des sillons, tout en gardant la même durée d’enregistrement.

Refusant de se plier à la norme d’un compétiteur, et dans un combat digne du duel Beta-VHS, RCA lança le format 45 RPM en réaction à la mise en marché du LP. L’idée était d’établir une norme équivalente au 78 RPM pour la durée d’enregistrement, mais offrant l’avantage d’une plus petite dimension et utilisant le principe du microsillon pour une performance légèrement améliorée. La guerre fut de courte durée cependant, et RCA dût se résigner à adopter en 1950 le système que Columbia avait laissé libre de droits afin de garantir qu’il s’établisse rapidement sur le marché. Le 45 RPM ne disparut pas pour autant, et il devint la norme pour les singles en musique populaire, ouvrant un marché parallèle.

Finalement, et pour couvrir tous les angles, le 16 RPM fit son apparition en même temps que le LP. La vitesse de rotation est en réalité 16 2/3 RPM, soit exactement la moitié de 33 1/3 RPM. On utilisait, dans la plupart des cas, un sillon plus étroit que sur un LP conventionnel et nommé Ultra-microgroove, question d’augmenter encore plus la durée d’enregistrement, évidemment au détriment de la qualité sonore. Ce standard fut utilisé principalement pour les livres-audio et les conférences enregistrées, mais aussi à l’occasion pour de la musique de fond.

Le choix de la vitesse de rotation étant réglé, on pouvait maintenant travailler à améliorer la performance du système. Certains manufacturiers spécialisés se mirent à fabriquer des disques issus de sessions Direct to Disc ; c’est-à-dire, en allant directement de la console d’enregistrement au tour à graver, comme on le faisait avant l’arrivée des enregistreurs à ruban magnétique, éliminant ainsi une étape du processus. Afin d’augmenter la fidélité, certains optèrent pour une vitesse de rotation de 45 RPM, puisque cette option était disponible sur toutes les platines vinyle.

Le disque avait par contre un problème fondamental qui ne pouvait être contourné : contrairement à un magnétophone où le ruban passe devant les têtes à vitesse constante grâce à l’utilisation d’un cabestan à vitesse de rotation fixe, la vitesse de défilement linéaire du sillon diminue au fur et à mesure que la pointe de lecture se rapproche de la fin du disque. La performance globale étant directement liée à la vitesse de défilement et non à la vitesse de rotation, en particulier dans les aigües, la qualité de reproduction se trouvait progressivement détériorée au cours de la lecture.

Pour une performance constante, la vitesse de rotation devrait varier en fonction de la position de la pointe de lecture sur le disque. Cela exigerait une mécanique et/ou une électronique excessivement complexes qui n’étaient pas disponibles lorsque le LP fut développé, ou encore elles auraient impliqué un coût de fabrication beaucoup trop élevé pour une grande diffusion. L’industrie ayant tendance à être très conservatrice à cette époque, on accepta de vivre avec cette faille pourtant importante.

Malgré les contraintes et limitations mentionnées plus haut, le LP continue à être utilisé de nos jours. L’interminable débat analogique VS numérique a même débordé du côté de cette étrange galette de vinyle, ce qui rend le marché encore plus complexe.

Chaque technologie présente évidemment un certain niveau d’imperfections, mais plus nous avançons dans le temps, plus nous nous rapprochons de la performance idéale. Il serait donc illusoire de croire que les technologies modernes, si elles sont bien utilisées évidemment, offriraient une performance inférieure à ce qui est essentiellement une version améliorée d’un vestige du XIXe siècle, ce qui équivaudrait à dire qu’une berline allemande de luxe moderne n’est pas supérieure à une De Dion-Bouton de 1895 sur le plan de la performance, sans mentionner le confort et l’aspect pratique…

Nous avons survolé le principe et la fabrication du disque vinyle au cours de la précédente chronique, essayons maintenant de voir plus en détail où se trouvent les faiblesses du LP en suivant le processus du début à la fin.

- À la base, et avant même d’aborder les contraintes électro-mécaniques, se trouve la question de la vitesse linéaire variable qui pose un problème incontournable, la performance ne peut être constante.

- Bien que la plage dynamique théorique d’un LP soit de 70 dB, en pratique elle dépasse rarement 50 dB. À titre de comparaison, un orchestre symphonique peut frôler le 110 dB d’écart, ce qui est l’équivalent de la limite d’un système numérique à 16 bits. La pleine dynamique de la musique sera donc obligatoirement compromise lorsque gravée sur vinyle. Le problème sera accentué s’il devient nécessaire de dépasser la durée optimale sur une face.

- Bien que les détails de la courbe RIAA aient été spécifiés avec précision lors de sa conception et que son utilisation soit incontournable pour une performance adéquate, certains compromis non normalisés doivent être faits pour tenir compte des limitations électromécaniques de la tête de gravure, principalement dans les extrêmes du spectre.

- La courbe RIAA introduit inévitablement des erreurs de phase importantes dues aux trois pôles de transition requis pour effectuer l’égalisation requise.

- Le procédé de gravure de la matrice est soumis à des contraintes électromécaniques importantes, incluant la masse de la partie mobile et la complexité de la charge présentée à l’amplificateur de puissance qui attaque les bobines de la tête de gravure.

- Les étapes d’électro-placage subséquentes, en nombre variable selon la façon de fonctionner des manufacturiers, introduisent de nouvelles erreurs dans les matrices de pressage résultantes.

- Le pressage introduit aussi un nombre important d’erreurs dues aux imperfections du matériau du biscuit ou à des débris qui peuvent s’introduire dans les matrices.

- À la reproduction, les mêmes problèmes qu’à la gravure se présentent : difficulté pour l’aiguille à suivre parfaitement le sillon et les erreurs de phase introduites par la courbe RIAA. Il est important de noter qu’il ne semble pas y a voir de consensus sur le circuit à utiliser pour obtenir la courbe idéale, et la plupart des manufacturiers utilisent des valeurs différentes, et même un nombre de pôles et de composantes différent, introduisant de nouvelles variables. Autre point, certains manufacturiers utilisent une égalisation passive alors que la plupart préfèrent les circuits actifs.

Cette série de contraintes signifie inévitablement que le processus altère de façon importante le signal d’origine. Le facteur le plus marquant est sans doute cette pratique des manufacturiers de ne pas adhérer rigoureusement à la courbe RIAA. Le résultat obtenu sera obligatoirement différent d’un appareil à l’autre, et pas nécessairement pour des raisons qualitatives.

On se revoit le mois prochain, alors que nous aborderons le second élément d’importance dans l’histoire la haute-fidélité, l’amplification électronique.

À suivre…